Álgebra lineal con aplicaciones

| 2. Álgebra de matrices | Ejercicios propuestos para el Capítulo 2.3 |

2.3 Multiplicación matricial

En la Sección 2.2 se introdujeron los productos matriz-vector. Si $\mathit{A}$ es una matriz de $m \times n$, el producto $\mathit{A}\mathbf{x}$ se definió para cualquier vector columna de $n$ componentes $\mathbf{x}$ en $\mathbb{R}^n$ de la siguiente manera: Si

$$ \mathit{A} = \begin{bmatrix} \mathbf{a}_1 & \mathbf{a}_2 & \cdots & \mathbf{a}_n \end{bmatrix} $$donde los $\mathbf{a}_j$ son las columnas de $\mathit{A}$, y si

$$ \mathbf{x} = \begin{bmatrix} x_1 \\ x_2 \\ \vdots \\ x_n \end{bmatrix} \text{, la Definición 2.5 dice} $$Esto fue motivado como una forma de describir sistemas de ecuaciones lineales con matriz de coeficientes $\mathit{A}$. De hecho, cada sistema de este tipo tiene la forma $\mathit{A}\mathbf{x} = \mathbf{b}$ donde $\mathbf{b}$ es el vector columna de constantes.

Nota: Ver la Definición 2.5

En esta sección extendemos la multiplicación matriz-vector a una forma de multiplicar matrices en general, y luego investigamos el álgebra matricial por sí misma. Aunque comparte varias propiedades de la aritmética ordinaria, pronto quedará claro que la aritmética matricial es diferente en varios aspectos. La multiplicación de matrices está estrechamente relacionada con la composición de transformaciones.

Composición y multiplicación de matrices

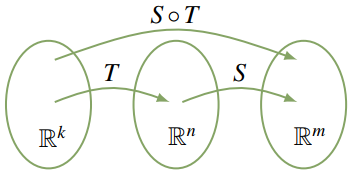

A veces, dos transformaciones se “encadenan” de la siguiente manera:

$$ \mathbb{R}^k \xrightarrow{T} \mathbb{R}^n \xrightarrow{S} \mathbb{R}^m $$En este caso, podemos aplicar $T$ primero y luego aplicar $S$, y el resultado es una nueva transformación

$$ S \circ T : \mathbb{R}^k \to \mathbb{R}^m $$llamada la compuesta de $S$ y $T$, definida por

$$ (S \circ T)(\mathbf{x}) = S[T(\mathbf{x})] \quad \text{para todo } \mathbf{x} \text{ en } \mathbb{R}^k $$La acción de $S \circ T$ se puede describir como “primero $T$ y luego $S$” (¡nótese el orden!). Esta nueva transformación se describe en el diagrama. El lector habrá encontrado la composición de funciones ordinarias: por ejemplo, considere $\mathbb{R} \xrightarrow{g} \mathbb{R} \xrightarrow{f} \mathbb{R}$ donde $f(x) = x^2$ y $g(x) = x+1$ para todo $x$ en $\mathbb{R}$. Entonces

$$ (f \circ g)(x) = f[g(x)] = f(x+1) = (x+1)^2 $$y

$$ (g \circ f)(x) = g[f(x)] = g(x^2) = x^2 + 1 $$para todo $x$ en $\mathbb{R}$.

Nuestra preocupación aquí son las transformaciones matriciales. Suponga que $\mathbf{A}$ es una matriz de $m \times n$ y $\mathbf{B}$ es una matriz de $n \times k$, y sea $\mathbb{R}^k \xrightarrow{T_\mathbf{B}} \mathbb{R}^n \xrightarrow{T_\mathbf{A}} \mathbb{R}^m$ las transformaciones matriciales inducidas por $\mathbf{B}$ y $\mathbf{A}$ respectivamente, es decir:

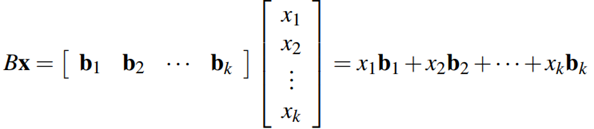

$$ T_{\mathbf{B}}(\mathbf{x}) = \mathbf{B}\mathbf{x} \text{ para todo } \mathbf{x} \text{ en } \mathbb{R}^k \quad \text{y} \quad T_{\mathbf{A}}(\mathbf{y}) = \mathbf{A}\mathbf{y} \text{ para todo } \mathbf{y} \text{ en } \mathbb{R}^n $$Escriba $\mathbf{B} = \begin{bmatrix} \mathbf{b}_1 & \mathbf{b}_2 & \cdots & \mathbf{b}_k \end{bmatrix}$ donde $\mathbf{b}_j$ denota la columna $j$ de $\mathbf{B}$ para cada $j$. Por lo tanto, cada $\mathbf{b}_j$ es un $n$-vector ($\mathbf{B}$ es $n \times k$) de modo que podemos formar el producto matriz-vector $\mathbf{A}\mathbf{b}_j$. En particular, obtenemos una matriz de $m \times k$

$$ \begin{bmatrix} \mathbf{A}\mathbf{b}_1 & \mathbf{A}\mathbf{b}_2 & \cdots & \mathbf{A}\mathbf{b}_k \end{bmatrix} $$con columnas $\mathbf{A}\mathbf{b}_1, \mathbf{A}\mathbf{b}_2, \ldots, \mathbf{A}\mathbf{b}_k$. Ahora, calcule $(T_{\mathbf{A}} \circ T_{\mathbf{B}})(\mathbf{x})$ para cualquier

$$ \mathbf{x} = \begin{bmatrix} x_1 \\ x_2 \\ \vdots \\ x_k \end{bmatrix} \text{ en } \mathbb{R}^k\text{:} $$ $$ \begin{aligned} (T_{\mathbf{A}} \circ T_{\mathbf{B}})(\mathbf{x}) &= T_{\mathbf{A}}[T_{\mathbf{B}}(\mathbf{x})] && \text{Definición de } T_{\mathbf{A}} \circ T_{\mathbf{B}} \\ &= \mathbf{A}(\mathbf{B}\mathbf{x}) \\ &= \mathbf{A}(x_1\mathbf{b}_1 + x_2\mathbf{b}_2 + \cdots + x_k\mathbf{b}_k) && \text{Ecuación 2.5 anterior} \\ &= \mathbf{A}(x_1\mathbf{b}_1) + \mathbf{A}(x_2\mathbf{b}_2) + \cdots + \mathbf{A}(x_k\mathbf{b}_k) && \text{Teorema 2.2.2} \\ &= x_1(\mathbf{A}\mathbf{b}_1) + x_2(\mathbf{A}\mathbf{b}_2) + \cdots + x_k(\mathbf{A}\mathbf{b}_k) && \text{Teorema 2.2.2} \\ &= \begin{bmatrix} \mathbf{A}\mathbf{b}_1 & \mathbf{A}\mathbf{b}_2 & \cdots & \mathbf{A}\mathbf{b}_k \end{bmatrix} \mathbf{x} && \text{Ecuación 2.5 anterior} \end{aligned} $$Debido a que $\mathbf{x}$ era un vector arbitrario en $\mathbb{R}^n$, esto muestra que $T_{\mathbf{A}} \circ T_{\mathbf{B}}$ es la transformación matricial inducida por la matriz $\begin{bmatrix} \mathbf{A}\mathbf{b}_1 & \mathbf{A}\mathbf{b}_2 & \cdots & \mathbf{A}\mathbf{b}_n \end{bmatrix}$. Esto motiva la siguiente definición.

Nota: Ver el Teorema 2.2.2

Por lo tanto, la matriz producto $AB$ se da en términos de sus columnas $\mathbf{Ab}_1$, $\mathbf{Ab}_2$, …, $\mathbf{Ab}_n$. La columna $j$ de $AB$ es el producto matriz-vector $\mathbf{Ab}_j$ de $A$ y la columna correspondiente $\mathbf{b}_j$ de $B$. Observe que dicho producto $\mathbf{Ab}_j$ tiene sentido por la Definición 2.5 porque $A$ es de $m \times n$ y cada $\mathbf{b}_j$ está en $\mathbb{R}^n$ (ya que $B$ tiene $n$ filas). Note también que si $B$ es una matriz columna, esta definición se reduce a la Definición 2.5 para la multiplicación matriz-vector.

Dadas las matrices $A$ y $B$, la Definición 2.9 y la computación anterior dan

para todo $\mathbf{x}$ en $\mathbb{R}^k$. Registramos esto como referencia.

He aquí un ejemplo de cómo calcular el producto AB de dos matrices utilizando la Definición 2.9.

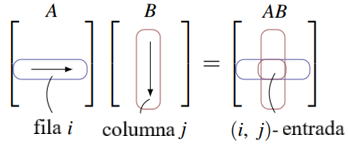

Si bien la Definición 2.9 es importante, existe otra manera de calcular el producto de matrices AB que permite determinar cada entrada individual. En la Sección 2.2 definimos el producto punto de dos n‑tuplas como la suma de los productos de las entradas correspondientes. Luego mostramos (Teorema 2.2.5) que si A es una matriz m × n y x es un vector de dimensión n, entonces la entrada j del producto Ax es el producto punto de la fila j de A con x. Esta observación fue llamada la ″regla del producto punto″ para la multiplicación matriz‑vector, y el siguiente teorema muestra que se extiende a la multiplicación de matrices en general.

Prueba. Escriba $B = [ \mathbf{b}_1 \ \mathbf{b}_2 \ \cdots \ \mathbf{b}_n ]$ en términos de sus columnas. Entonces $\mathbf{Ab}_j$ es la columna $j$ de $AB$ para cada $j$. Por lo tanto, la entrada $(i, j)$ de $AB$ es la entrada $i$ de $\mathbf{Ab}_j$, que es el producto punto de la fila $i$ de $A$ con $\mathbf{b}_j$. Esto prueba el teorema. $\square$

Así, para calcular la entrada (i, j) de AB, proceda de la siguiente manera (véase el diagrama): Recorra la fila i de A y la columna j de B, multiplique las entradas correspondientes y sume los resultados.

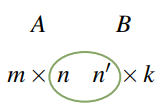

Nótese que esto requiere que las filas de A tengan la misma longitud que las columnas de B. La siguiente regla es útil para recordar este hecho y para determinar el tamaño de la matriz producto AB.

Regla de compatibilidad

Sean A y B matrices. Si A es de tamaño m × n y B es de tamaño n′ × k, el producto AB puede formarse si y solo si n = n′. En este caso, el tamaño de la matriz producto AB es m × k, y decimos que AB está definido, o que A y B son compatibles para la multiplicación.

El diagrama proporciona una regla mnemotécnica útil para recordar esto. Adoptamos la siguiente convención:

Convención

Siempre que se escribe un producto de matrices, se asume tácitamente que los tamaños de los factores son tales que el producto está definido. ♦

Para ilustrar la regla del producto punto, recalculamos el producto de matrices en el Ejemplo 2.3.1.

Nota: En cuanto a los números, escribimos A2 = A·A, A3 = A·A·A, etc. Nótese que A2 está definido si y solo si A tiene tamaño n × n para algún n.

A diferencia de la multiplicación numérica, los productos de matrices AB y BA no necesitan ser iguales. De hecho, ni siquiera necesitan tener el mismo tamaño, como muestra el Ejemplo 2.3.5. Resulta poco común que AB = BA (aunque no es imposible), y se dice que A y B conmutan cuando esto ocurre.

El siguiente teorema recopila varios resultados sobre la multiplicación de matrices que se utilizan en todas partes en álgebra lineal.

Prueba. La condición (1) es el Ejemplo 2.3.7; probamos (2), (4) y (6) y dejamos (3) y (5) como ejercicios.

2. Si $C = [ \mathbf{c}_1 \ \mathbf{c}_2 \ \cdots \ \mathbf{c}_k ]$ en términos de sus columnas, entonces $BC = [ B\mathbf{c}_1 \ B\mathbf{c}_2 \ \cdots \ B\mathbf{c}_k ]$ por la Definición 2.9, por lo que

4. Sabemos (Teorema 2.2.2) que $(B+C)\mathbf{x} = B\mathbf{x} + C\mathbf{x}$ se cumple para cada vector columna $\mathbf{x}$. Si escribimos $A = [ \mathbf{a}_1 \ \mathbf{a}_2 \ \cdots \ \mathbf{a}_n ]$ en términos de sus columnas, obtenemos

6. Como en la Sección 2.1 , escriba $A = [a_{ij}]$ y $B = [b_{ij}]$, de modo que $A^T = [a’_{ij}]$ y $B^T = [b’_{ij}]$ donde $a’_{ij} = a_{ji}$ y $b’_{ij} = b_{ji}$. Si $c_{ij}$ denota la entrada $(i, j)$ de $B^T A^T$, entonces $c_{ij}$ es el producto punto de la fila $i$ de $B^T$ con la columna $j$ de $A^T$. Por lo tanto,

Pero este es el producto punto de la fila $j$ de $A$ con la columna $i$ de $B$; es decir, la entrada $(j, i)$ de $(AB)^T$. Esto prueba (6). $\square$

Nota: Acceder fácilmente al Teorema 2.3.1

La propiedad 2 en el Teorema 2.3.3 se llama la ley asociativa de la multiplicación de matrices. Afirma que la ecuación A(BC) = (AB)C se cumple para todas las matrices (si los productos están definidos). Por lo tanto, este producto es el mismo sin importar cómo se forme, y por eso se escribe simplemente como ABC. Esto se extiende: El producto ABCD de Se pueden formar cuatro matrices de varias maneras, por ejemplo, (AB)(CD), [A(BC)]D y A[B(CD)], pero la ley asociativa implica que todas son iguales y, por lo tanto, se escriben como ABCD. Una observación similar se aplica en general: los productos de matrices pueden escribirse de manera inequívoca sin paréntesis.

Sin embargo, debe tomarse una nota de precaución sobre la multiplicación de matrices: el hecho de que AB y BA no necesariamente sean iguales significa que el orden de los factores es importante en un producto de matrices. Por ejemplo, ABCD y ADCB pueden no ser iguales.

Advertencia: Si se cambia el orden de los factores en un producto de matrices, la matriz resultante puede cambiar (o puede no estar definida). ¡Ignorar esta advertencia es una fuente de muchos errores entre los estudiantes de álgebra lineal!

Las propiedades 3 y 4 en el Teorema 2.3.3 se denominan leyes distributivas. Afirman que A(B + C) = AB + AC y (B + C)A = BA + CA se cumplen siempre que las sumas y productos estén definidos. Estas reglas se extienden a más de dos términos y, junto con la Propiedad 5, aseguran que muchas manipulaciones familiares del álgebra ordinaria se extiendan a las matrices. Por ejemplo,

A(2B − 3C + D − 5E) = 2AB − 3AC + AD − 5AE

(A + 3C − 2D)B = AB + 3CB − 2DB

Note nuevamente que la advertencia sigue en vigor: por ejemplo, A(B − C) no necesariamente es igual a AB − CA. Estas reglas permiten simplificar muchas expresiones matriciales.

El Ejemplo 2.3.9 y el Ejemplo 2.3.10 a continuación muestran cómo podemos usar las propiedades del Teorema 2.3.2 para deducir otros hechos sobre la multiplicación de matrices. Se dice que las matrices A y B conmutan si AB = BA.

En la Sección 2.2 vimos (en el Teorema 2.2.1) que todo sistema de ecuaciones lineales tiene la forma

Ax = b,

donde A es la matriz de coeficientes, x es la columna de variables y b es la matriz de constantes. Así, el sistema de ecuaciones lineales se convierte en una única ecuación matricial. La multiplicación de matrices puede proporcionar información sobre dicho sistema.

Las ideas del Ejemplo 2.3.11 llevan a información importante sobre matrices; esto se abordará en la siguiente sección.

Multiplicación por bloques

Por ejemplo, escribir una matriz $B$ en la forma $B = [ \mathbf{b}_1 \ \mathbf{b}_2 \ \cdots \ \mathbf{b}_k ]$ donde $\mathbf{b}_j$ son las columnas de $B$ es una partición en bloques de $B$. Aquí hay otro ejemplo. Considere las matrices

donde los bloques han sido etiquetados como se indica. Esta es una forma natural de particionar $A$ en bloques debido a los bloques $I_2$ y $0_{23}$ que ocurren. Esta notación es particularmente útil cuando multiplicamos las matrices $A$ y $B$ porque el producto $AB$ puede calcularse en forma de bloques como sigue:

Esto se puede comprobar fácilmente que es el producto AB, calculado de la manera convencional.

En otras palabras, podemos calcular el producto AB mediante la multiplicación ordinaria de matrices, usando bloques como entradas. El único requisito es que los bloques sean compatibles. Es decir, los tamaños de los bloques deben ser tales que todos los productos (de matrices) de bloques que se presenten tengan sentido. Esto significa que el número de columnas en cada bloque de A debe ser igual al número de filas en el bloque correspondiente de B.

Omitimos la prueba del anterior Teorema.

Hemos estado utilizando dos casos de multiplicación por bloques. Si $B = \begin{bmatrix} \mathbf{b}_1 & \mathbf{b}_2 & \cdots & \mathbf{b}_k \end{bmatrix}$ es una matriz donde las $\mathbf{b}_j$ son las columnas de $B$, y si el producto matricial $AB$ está definido, entonces tenemos

$$AB = A \begin{bmatrix} \mathbf{b}_1 & \mathbf{b}_2 & \cdots & \mathbf{b}_k \end{bmatrix} = \begin{bmatrix} A\mathbf{b}_1 & A\mathbf{b}_2 & \cdots & A\mathbf{b}_k \end{bmatrix}$$Esta es la Definición 2.9 y es una multiplicación en bloque donde A = [A] tiene solo un bloque. Como otra ilustración,

dónde x es cualquier matriz columna de k × 1 (esta es la Definición 2.5).

No es nuestra intención abordar la multiplicación de bloques en detalle aquí. Sin embargo, damos un ejemplo adicional porque se utilizará más adelante.

Suponga que las matrices $A = \begin{bmatrix} B & X \\ 0 & C \end{bmatrix}$ y $A_1 = \begin{bmatrix} B_1 & X_1 \\ 0 & C_1 \end{bmatrix}$ están particionadas como se muestra, donde $B$ y $B_1$ son matrices cuadradas del mismo tamaño, y $C$ y $C_1$ también son cuadradas del mismo tamaño. Estas son particiones compatibles y la multiplicación por bloques resulta en:

$$AA_1 = \begin{bmatrix} B & X \\ 0 & C \end{bmatrix} \begin{bmatrix} B_1 & X_1 \\ 0 & C_1 \end{bmatrix} = \begin{bmatrix} BB_1 & BX_1 + XC_1 \\ 0 & CC_1 \end{bmatrix}$$La multiplicación por bloques tiene usos teóricos, como veremos. Sin embargo, también es útil para calcular productos de matrices en una computadora con capacidad de memoria limitada. Las matrices se dividen en bloques de tal manera que cada producto de bloques se pueda manejar. Luego, los bloques se almacenan en memoria auxiliar y sus productos se calculan uno por uno.

Grafos Dirigidos

El estudio de los grafos dirigidos ilustra cómo la multiplicación de matrices surge de maneras distintas al estudio de ecuaciones lineales o transformaciones de matrices.

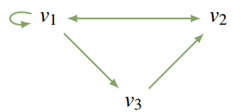

Un grafo dirigido consiste en un conjunto de puntos (llamados vértices) conectados por flechas (llamadas aristas). Por ejemplo, los vértices podrían representar ciudades y las aristas, vuelos disponibles. Si el grafo tiene $n$ vértices $v_1, v_2, \ldots, v_n$, la matriz de adyacencia $A = [a_{ij}]$ es la matriz de $n \times n$ cuya entrada $(i, j)$, $a_{ij}$, es $1$ si existe una arista desde $v_j$ a $v_i$ (observe el orden), y cero en caso contrario. Por ejemplo, la matriz de adyacencia del grafo dirigido que se muestra es$$A = \begin{bmatrix} 1 & 1 & 0 \\ 1 & 0 & 1 \\ 1 & 0 & 0 \end{bmatrix}.$$